Еще одним вариантом специализированного Linux-дистрибутива, ориентированного на создание высокопроизводительного кластера, является Rocks Cluster Distribution. Одним из преимуществ использования Rocks является простота построения и управления кластером. Одно из важных свойств данного дистрибутива является возможность построения кластера как с использованием полнокомплектных компьютераов, так и с использованием бездисковых станций.

Дистрибутив Rocks прострен на основе Red Hat Linux, и следующее оборудование:

Процессоры

|

Сетевое оборудование

|

Физически Rocks кластер состоит из двух или более узлов одного из следующих типов:

FrontendУзлы этого типа предназначены для доступа к кластеру пользователей либо извне локальной сети (через интернет), либо непосредственно с консоли. То есть они выступают в роли консоли кластера, к которым пользователи имеют возможность подключиться (login), откомпилировать на них свои программы и запустить задания на исполнение. На узлах данного типа запущено большое количество сервисов (NFS, NIS, DHCP, NTP, MySQL, HTTP, ...). Администрирование таких узлов требует от сисадмина определенного уровня компетенции. Как минимум один frontend-узел должен присуствовать для нормального функционирования кластера.

Обычно узлы данного типа имеют следующие характеристики:

- Две сетевых карты - одна для приватной сети кластера, другая для подключения к внешним сетям.

- Большой объем дискового пространства для для хранения пользовательских программ и данных.

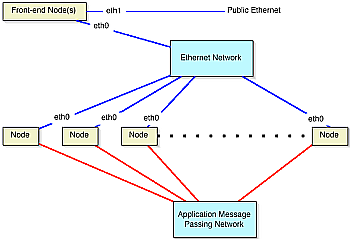

Архитектура Rocks-кластера диктует следующую схему подключения узлов к сети:

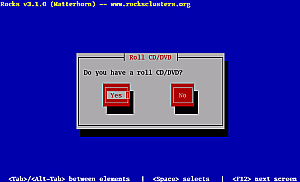

Далее рассмотрим процедуру установки кластера, которая начинается с установки операционной системы на frontend-узел. Для установки необходимы два CD: Rocks Base CD и HPC Roll CD. Загрузка начинается с диска Rocks Base CD. При появлении начального логотипа вы должны указать способ загрузки: frontend. Обратите внимание, режимом загрузки по умолчанию является режим compute, причем время паузы перед загрузкой достаточно мало, поэтому не пропустите предложение выбрать режим. После того, как программа установки frontend-узла будет запущена, через некоторое время на экране появится следующий вопрос:

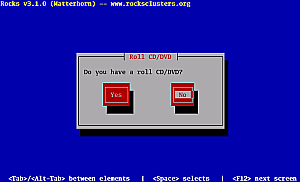

Чтобы добавить необходимый для frontend-режима пакет HPC Roll, ответьте на этот вопрос "Yes", и после того, как ваш CD-привод откроется, поместите в него HPC Roll CD. Для установки HPC Roll нажмите "Yes", и когда диск опознается системой вы увидите окошко с надписью Found Roll 'hpc'. Далее, когда система предлжит вам устоновить дополнительный пакет, ответьте отказом:

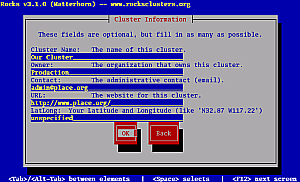

После этого система попросит вас вставить в CD-привод исходный пакет Rocks Base CD. Сделайте это и нажмите "Ok". Далее система попросит вас заполнить форму информации об устанавливаемом кластере:

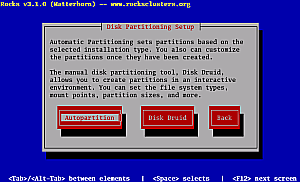

Заполните ее и нажмите "Ok". Следующий этап установки кластера - разбиение вашего жесткого диска на разделы. Вы можете эту работу выполнить самостоятельно или доверить ее процедуре установки. В последнем случае все необходимые разделы будут созданы и отформатированы автоматически.

Обычно имеет смысл для простоты работы выбрать автоматический режим. В этом случае мы выбараем пункт меню "Autopartition". Далее мы перейдем к определению конфигурации сетевых интерфейсов.

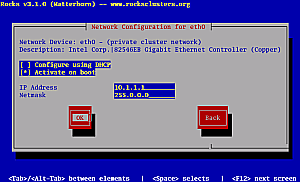

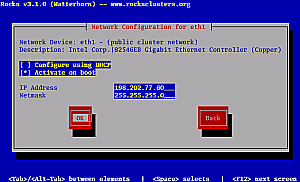

В случае, если у нас имеется две сетевых карты, как это было описано выше, предыдущая картинка у вас появится дважды. Превый раз мы определяем сетевый реквизиты приватной сети. Реквизиты могут быть заданы как вручную, так и автоматически с помощью имеющегося DHCP-сервера. Для приватной сети рекомендуется ручной режим. После того, как мы определили ip-адрес и маску подсети для приватной сети, аналогично задаем сетевые реквизиты для второй сетевой карты (для публичной сети), то есть для карты, через котроую будет осуществлятся связь кластера с внешним миром.

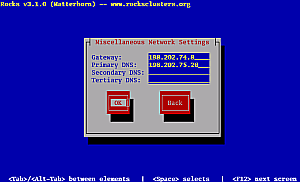

После того, как мы задали ip-адреса сетевых карт, указываем системе адрес шлюза и DNS-сервера:

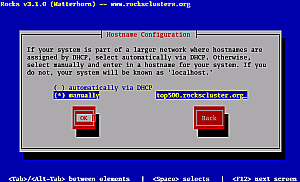

И, напоследок задаем доменное имя нашей frontend-машины:

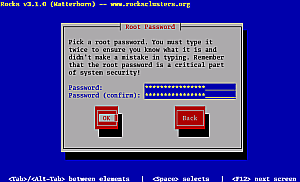

Далее определяем пароль суперпользователя:

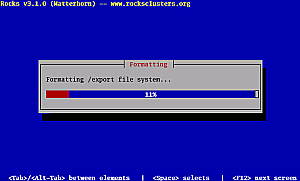

Теперь все основные параметры заданы и система начинает форматировать винчестер:

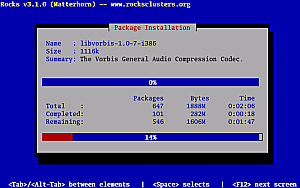

После успешного разбиения диска на разделы и форматирования разделов начинается установка пакетов:

После установки пакетов с первого диска инсталлятор попросит вас вставить те дополнительные диски пакетов, которые вы выбрали в самом начале. После того, как все диски будут установлены, система перезагружается. На этом установка frontend-узла завершается.

Переходим к установке compute-узлов. В самом простом варианте дополнительнуе узлы кластера у нас будут бездисковыми. В качестве альтернативы может рассматриваться вариант, когда в качестве узлов кластера используются имеющиеся рабочие станции с установленной операционной системой (например Windows). В этом случае загрузка таких компьютеров осуществляется не обычным образом, а по сети (PXE), если это позволяют сетевые карты или с дискеты, образ которой, соответствующий имеющейся в компьютере карте, можно взять с сайта www.rom-o-matic.net. В случае, если вы не хотите использовать удаленную загрузку системы, а, вместо этого, желаете установить на compute-ноды нормальную ОС, процедура установки будет аналогича описанной выше.

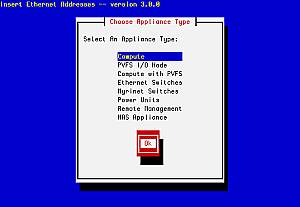

Итак, устанавливаем бездисковые compute-ноды. Для этого мы должны подключиться к только что установленному нами frontend-узлу под именем root. Из командной строки запускаем программу insert-ethers. Эта программа перехватывает DHCP-запросы от загружаемых compute-нод и сохраняет информацию о них в базе данных Rocks. Следующий скриншот показывает картинку, которая появится у вас в результате запуска insert-ethers.

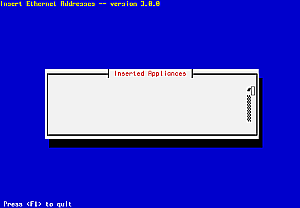

Выберите пункт меню по умолчанию (Compute) и нажмите "OK". В результате вы увидите такую картинку:

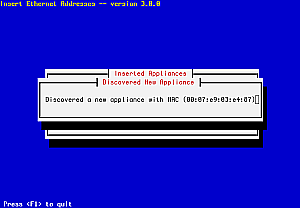

Это означает, что программа ждет появления в сети новых compute-узлов. Включите первую бездисковую стацию, сконфигурировав ее для удаленной загрузки по сети. В тот момент, когда frontend получит DHCP-запрос от compute-узла вы увидите на экране картинку примерно следующего содержания:

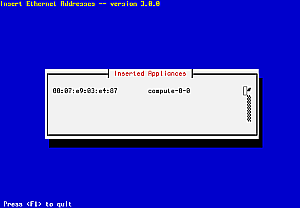

Эта картинка означает, что insert-ethers приняла DHCP-запрос от compute-ноды, внесла полученную информацию в базу данных и обновила конфигурационные файлы. Картинка продержится на экране несколько секунд, после чего сменится на примерно следующее:

В этот момент начинается установка операционной системы на compute-узел. Аналогичную процедуру проведите для всех остальных compute-узлов. После того, как все узлы кластера будут установлены, выйдите из программы insert-ethers, нажав "F1".